Wenn in ganz Europa die Lichter ausgehen – Überraschung: Auch im Winter kann es Flauten geben

stopthesethings

Der Punkt ist erreicht, an dem seriöse Menschen beginnen, ernsthaft über Stromerzeugung zu sprechen. Europa wurde von Windflaute heimgesucht, und der Strom aus Wind ist, wie vorhersehbar, stark zurückgegangen. Die Katastrophe eines Blackouts, die vor kurzen die Menschen auf dem ganzen Kontinent bedroht hat, wird sich in immer kürzeren Abständen wiederholen.

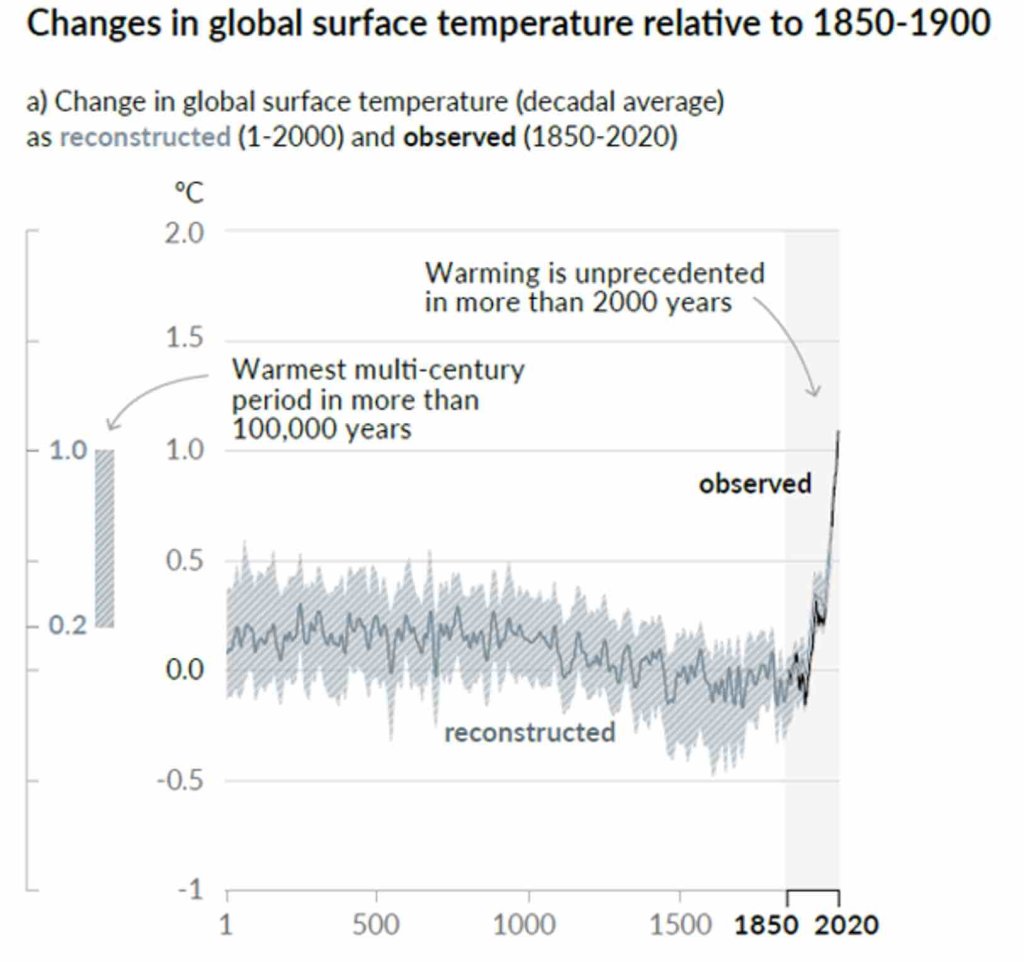

Die Vorstellung, dass moderne, industrielle Volkswirtschaften mit Sonnenschein und Wind betrieben werden könnten, war schon immer völliger Unsinn. Aber wie der gereizte Teenager, der es auf die harte Tour lernen will, muss sich Europa endlich mit den Konsequenzen auseinandersetzen, wenn man träumerische Ideologien vor bewährte Technik und Ökonomie bevorzugt.

Agorameter Okt2021 Deutschland

https://www.agora-energiewende.de/service/agorameter/chart/power_generation/24.09.2021/25.10.2021/today/

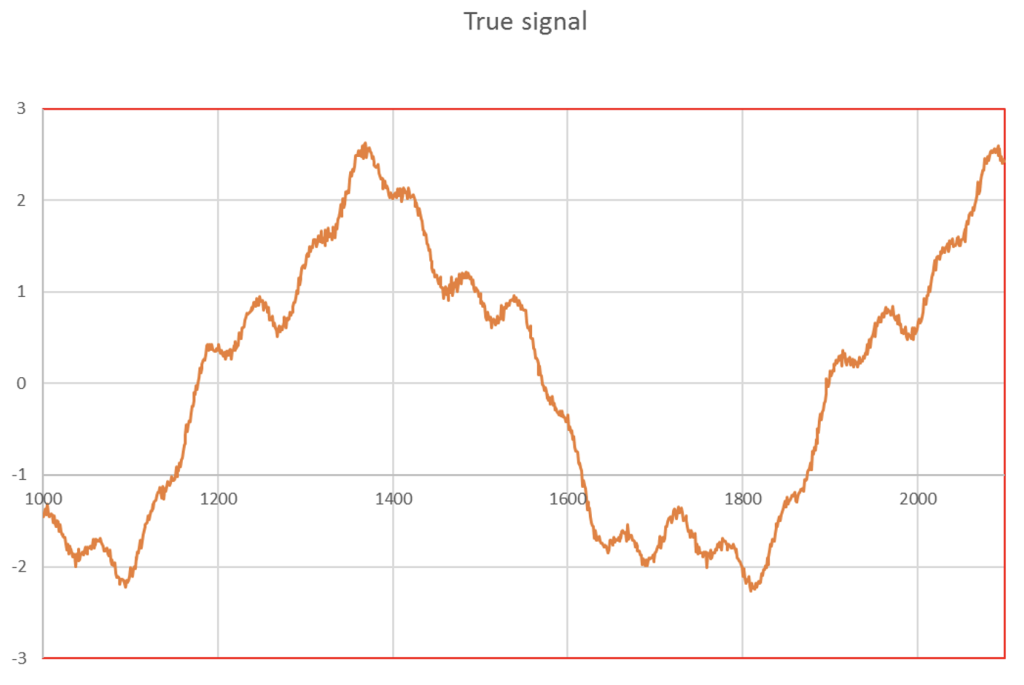

Aktuelle Energieversorgung. Am 7-8. Okt. betrug der Gesamtbedarf mehr als 76 GW – Es wurden 6 GW von Wasser und Biomasse geliefert, tagsüber noch etwas Sonnenstrom hinzu. – Der große Rest … wie üblich.

Wir können es uns nicht leisten, unser Land nach den Launen des Winds auszurichten

RT, Rob Lyons

Europas Verzweiflung eine ideologische Netto-Null zu erreichen, die religiöse Hingabe an erneuerbare Energien wie Wind- und Sonne und ihre unwissenschaftliche Ablehnung der Atomkraft sind ein Rezept für eine unglaublich teure Katastrophe.

Die Energiepreise sind in den letzten Wochen in die Höhe geschossen. Während ein Teil dieses Anstiegs darauf zurückzuführen ist, dass die Weltwirtschaft aus einem durch die Sperrung verursachten Schlummer erwacht, läuten die Alarmglocken darüber, wie große westliche Volkswirtschaften im Wahnsinn in eine „Netto-Null“-Welt zu abhängig von angeblich heilsbringenden „erneuerbaren Energien“ geworden sind.

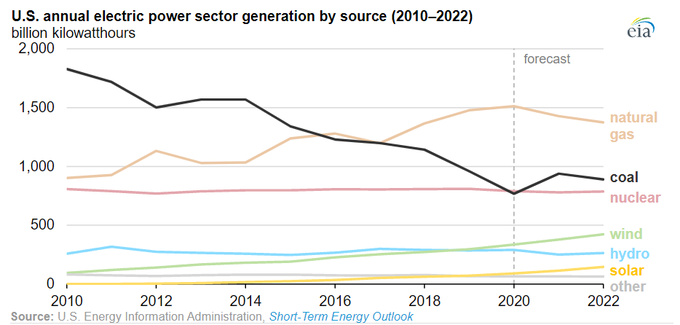

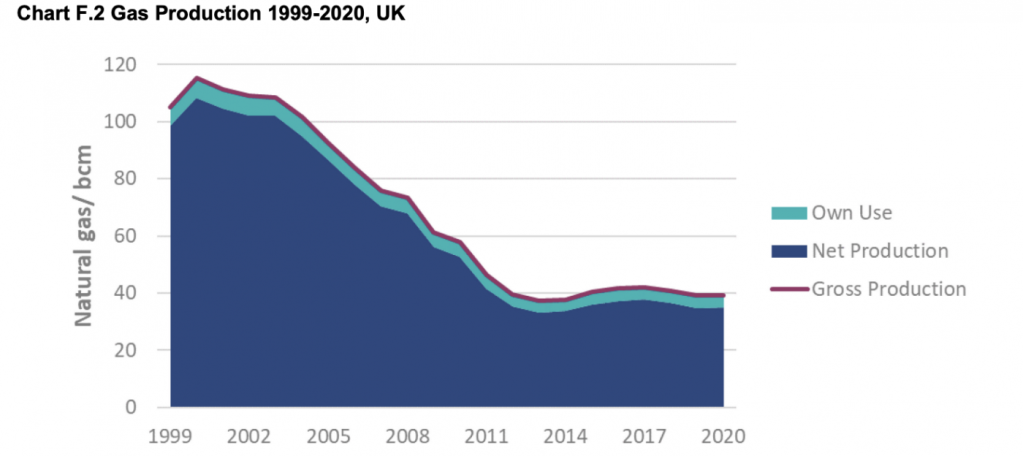

Das Wall Street Journal berichtete Anfang dieser Woche, dass schwache Winde in der Nordsee den Energienetzen große Kopfschmerzen bereiten. „Die plötzliche Verlangsamung der windbetriebenen Stromproduktion vor der Küste Großbritanniens in den letzten Wochen hat die regionalen Energiemärkte erfasst. Gas- und Kohlekraftwerke wurden hinzugezogen, um den Mangel an Wind auszugleichen.“

Bei all den Beschwörungen – und riesigen Subventionen – für erneuerbare Energien in den letzten Jahren sind sie ein Albtraum für eine moderne Gesellschaft geworden, in der rund um die Uhr Energie benötigt wird. Der Wind weht dieses Jahr weniger als sonst. Ein Energieberater erklärte letzte Woche gegenüber der Financial Times :

„Es ist normal, dass die Winderzeugung saisonal schwankt, aber in diesem Sommer ist die Erzeugung noch niedriger als in den Vorjahren – alles hängt mit dem Sommer zusammen, den wir in ganz Europa hatten, in dem es warm und trocken und weniger windig war.“

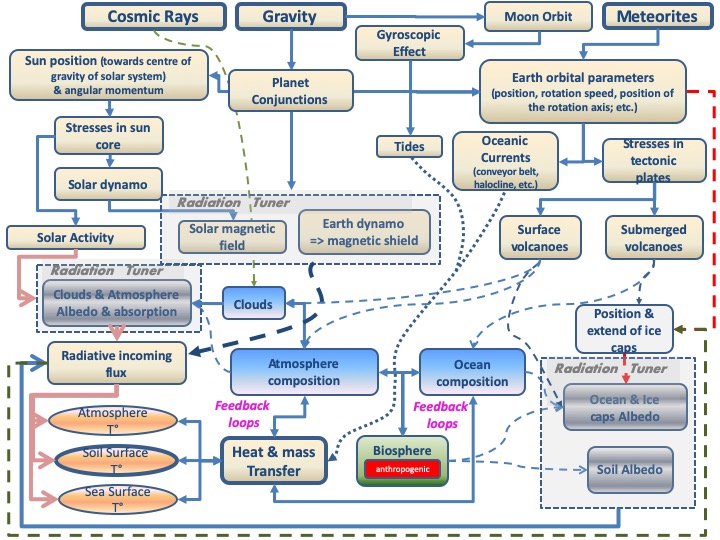

Das Bestreben, die Gesellschaft klimaneutral zu machen, hat uns den Elementen ausgeliefert – [wie vor der „industriellen Revolution“ und] das genaue Gegenteil des menschlichen Fortschritts. Darüber hinaus befinden wir uns, wie die deutsche Energiepolitik zeigt, tatsächlich in einer Doppelfalle, denn es gibt nicht nur Windstille, sondern auch viel zu windige Zeiten.

Wie Fans erneuerbarer Energien gerne prahlen, hat in Europa die Stromerzeugung aus Windkraft einen immer größeren Anteil [aufs Jahr gerechnet]. In einem kürzlich erschienenen Artikel in Foreign Policy heißt es: „…2020 war für Deutschland ein Paradejahr in der Produktion erneuerbarer Energien. Saubere Energiequellen – Windparks und Solaranlagen sowie Wasser- und Biogasanlagen – haben ihren Anteil am Stromverbrauch auf bis zu 46 % erhöht, was fast dem von Kohle, Gas, Öl und Atomkraft zusammen entspricht.“

Aber was passiert, wenn der Wind weht, aber gerade nicht so viel Strom gebraucht wird? Wie der Artikel in Foreign Policy feststellt: „Stürmische Tage können so windig sein, dass die Stromflüsse aus Windparks on- und offshore das Stromnetz überwältigen und sogar zum Zusammenbruch führen. Diese Stromtsunamis können die Stabilität der Energiesysteme auch der Nachbarländer bedrohen. Darüber hinaus können die Preise bei Stromüberschuss im Netz negativ werden und die Netzbetreiber zwingen, Großkunden wie Betreiber von Pumpspeichern für die Abnahme des Stroms zu bezahlen.“ Anstatt Strom zu verkaufen, sind deutsche Stromerzeuger gezwungen, diese Abnehmer dafür zu bezahlen, dass sie diesen Strom nehmen. Das ist die Ökonomie des Wahnsinns.

Aber es kommt noch schlimmer. Die im September 2010 von der Bundesregierung skizzierte Energiewende ist eine Politik der Umstellung auf kohlenstoffarme Energieträger. Der Tsunami mit Ausfall des dortigen Kernkraftwerks in Fukushima führte jedoch ein halbes Jahr nach seinem Ereignis dazu, dass die Regierung auch die deutschen Kernkraftwerke stilllegte und das Land ausschließlich von erneuerbaren Energien abhängig machen will.

Wie ein Artikel im Spiegel von 2019 enthüllte, ist das Resultat enorm teuer. In den vergangenen fünf Jahren hat die Energiewende Deutschland jährlich 32 Milliarden Euro gekostet. Eine in dem Artikel zitierte Schätzung beziffert die Gesamtkosten für die Verfünffachung der deutschen Wind- und Solarleistung auf 3,4 Billionen Euro.

Der Drang, immer mehr Windkraftanlagen zu errichten, provozierte laut den Autoren eine Gegenreaktion derer, die sowohl im Schatten dieser riesigen Maschinen lebten als auch immer mehr Kabel und Masten ertragen mussten, die sich über die Landschaft ausbreiteten. „Die Politiker fürchten den Widerstand der Bürger. Es gibt kaum ein Windenergieprojekt, das nicht bekämpft wird.“

Führen all diese Ausgaben zu geringeren Emissionen? Überhaupt nicht. Tatsächlich sind die Emissionen in Deutschland gestiegen, weil durch die Abschaffung der Kernkraft etwas anderes geschaffen werden musste, um die Lücken zu füllen, wenn der Wind nicht weht und die Sonne nicht scheint. Da war etwas anderes– warten Sie… – Kohle. Deutschland damit abhängig von den CO2 absondernden fossilen Brennstoffen geworden, dass die Regierung im vergangenen Jahr angekündigt hat, die Kohle erst 2038 auslaufen zu lassen.

Es ist eine Sache, erneuerbare Energien ins Stromnetz aufzunehmen. Wenn der Wind mit der richtigen Geschwindigkeit bläst und die richtige Nachfrage besteht, können sich Umweltschützer damit rühmen, dass die Stromerzeugung „kohlenstofffrei“ ist. Aber wenn die Nachfrage zu groß ist, müssen diese – noch vorhandenen, fossil befeuerten Gas- und Kohlekraftwerke mit großem Aufwand erst angeheizt werden. Die Anlagenbesitzer können Strom heutzutage nur für kürzere Zeiträume, oft unbekannter Dauer verkaufen [Einspeisevorrang, wenn wieder mal Wind oder Sonne da ist]. Trotz allem müssen die Kosten gedeckt werden. Und wenn die Nachfrage zu gering ist, wird Strom im Netz „verklappt“ (siehe oben), was ebenfalls Geld kostet.

Wind- und Solarenergie können eine moderne Wirtschaft einfach nicht zuverlässig und wirtschaftlich antreiben. Eine Möglichkeit, das Problem zu umgehen, besteht darin, Holz zu verbrennen (möglicherweise noch schlimmer für die Emissionen als Kohle) und zu behaupten, es sei kohlenstoffarm und erneuerbar, weil man dann wieder Bäume pflanzt, die Kohlenstoff aus der Atmosphäre aufnehmen. Selbst der Öko-Wachhund der britischen Regierung, der Committee on Climate Change [~Ausschuss für Klimaänderungen], glaubt das nicht und forderte 2018, dass große Biomasseanlagen vermieden werden sollten, es sei denn, sie werden von einer CO2-Abscheidung und -Speicherung begleitet.

Deutschland war eines der reichsten Länder der Welt. Aber selbst umweltfreundliche Deutsche beginnen zu erkennen, dass die derzeitige kohlenstoffarme Technologie – abgesehen von Kernkraft – zu teuer und unzuverlässig ist. Wenn angesichts eines so grundlegenden Problems die Politik zur CO2-Reduzierung beibehalten wird, wird das Ergebnis eine teure Katastrophe sein.

Übersetzt durch Andreas Demmig